Questions Dataflow sur Dataverse

Questions Dataflow sur Dataverse

Quelqu’un s’y connaîtrait-il en Dataflow avec Dataverse ?

Mes questions…

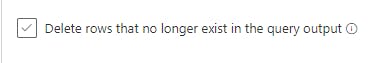

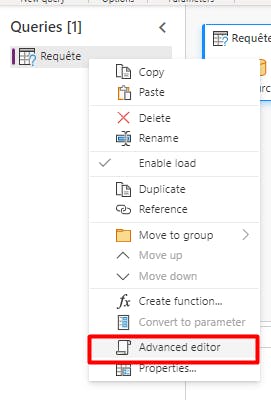

Est-ce que l’on peut paramétrer un dataflow pour qu’il fasse de l’annule-et-remplace ? C’est à dire qu’il vide la table cible avant de la remplir…

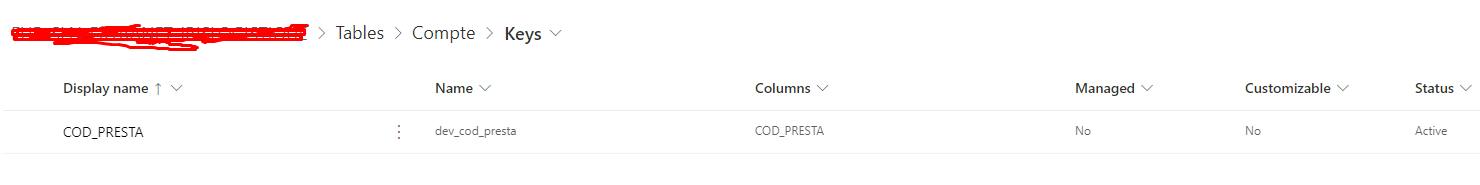

Si je lance un Dataflow 2x de suite, est-ce qu’il va me créer des doublons ou il fait bien de la synchro (ne crée que ce qui a besoin d’être créé, ne modifie que ce qui a besoin d’être modifié) ?

Je sais que Dataflow ne gère pas les tables avec des relations N-N mais je suppose qu’il sait gérer les relations 1-N exact ? Si oui, y a-t-il quelque chose de particulier à faire ou auquel il faut faire attention pour que ça marche bien ?

Merci 😊

PostID=ZCTKnIyS9jBkZgF

Connectez-vous pour répondre.